Gouvernementalité algorithmique et justice spatiale

Algorithmic governmentality and spatial justice

« Solve intelligence. Use it to make the world a better place ». C’est par cette accroche pour le moins explicite que s’ouvre la page d’accueil de Google DeepMind, une société d’intelligence artificielle britannique initialement basée à l’University College London et rachetée en janvier 2014 par le géant de l’internet Google pour la modique somme de 400 millions de livres sterling[1] (Shead, 2016). L’objectif affiché est clair : en croisant neurosciences et capacités de calcul, Google DeepMind veut construire des machines apprenantes généralistes, et donc recréer le cerveau humain et ses capacités de calcul.

“Solve intelligence. Use it to make the world a better place.” It is this unabashedly explicit strapline that adorns the homepage of Google DeepMind, a British artificial intelligence company initially based at University College London and taken over in January 2014 by the Internet giant Google for the modest sum of 400 million pounds sterling (Shead 2016).[1] The stated goal is clear: by combining neuroscience and computing capacity, Google DeepMind wants to build general learning machines that will recreate the computing capacities of the human brain).

Il est significatif que Google soit ici à la manoeuvre : les opérateurs de réseaux sociaux sont en effet au coeur de l’actualité du débat contemporain sur le Big Data, ces données massives produites par notre utilisation constante des réseaux et désormais stockées, accessibles et exploitables par des algorithmes de plus en plus sophistiqués. La notion de système intelligent, quel que soit son champ d’application, est désormais déployée à tout le spectre des activités humaines pour en permettre l’optimisation : nos objets du quotidien (téléphones, tablettes, etc.) sont smart, et font de nous des consommateurs plus efficaces aux profils mieux identifiés. Par changement d’échelle, nos villes aussi deviennent smart, les données produites massivement par différents capteurs permettant d’en informer et d’en optimiser les systèmes de gestion.

It is significant that Google is the player here: social network operators are at the heart of the contemporary debate on Big Data, the massive quantities of information generated by our continuous use of social networks and now stored, accessible and exploitable by ever more sophisticated algorithms. The notion of smart systems, whatever the field of application, has now spread to the whole spectrum of human activities: our day-to-day objects (telephones, tablets, etc.) are smart, making us more efficient consumers with better identified profiles. Moving up a scale, our cities are also becoming smart, as swarms of sensors capture massive quantities of data that are employed to guide and optimise urban management systems.

Mais ce tableau idéal du chiffre au service du progrès ne serait pas complet sans l’idée d’un changement radical qui sous-tend les débats sur le Big Data : les données massives, travaillées par des algorithmes de plus en plus sophistiqués et de plus en plus autonomes de la pensée humaine, doivent permettre in fine la prédiction (et donc l’encadrement) des conduites (Pentland, 2014). En effet, la mise à disposition de quantités astronomiques de données de nature de plus en plus variée, l’accroissement de la vitesse de circulation et de traitement qui caractérisent le Big Data feraient de celles-ci une révolution épistémique, celle des 3V (volume, vélocité, variété). Elles permettraient ainsi de s’affranchir de toute recherche de causalité en autorisant une démarche totalement inductive basée sur la détection de corrélations entre des données collectées massivement tous azimuts, et de se débarrasser ainsi du biais typiquement humain que représente la formulation d’hypothèses de travail. La compréhension des phénomènes passerait donc au second plan (voire n’aurait plus aucune importance), au profit de la prévisibilité.

However, this idealised picture of data-driven progress would not be complete without the idea of radical change that underlies the debates on Big Data: mass data, processed by algorithms that are not only ever more sophisticated but increasingly independent of human thought, will ultimately make it possible to predict (and therefore to manage) behaviours (Pentland 2014). Indeed, because of the availability of astronomical quantities of data of an increasingly varied nature, and the higher flows and processing speed, Big Data is considered an epistemic revolution, the so-called 3V (volume, velocity, variety) revolution. It is seen as removing the need for any pursuit of causality, by permitting a totally inductive approach involving the detection of correlations between massive quantities of across-the-board data, and therefore avoiding the typically human bias represented by the formulation of working hypotheses. As a result, the understanding of phenomena becomes secondary (or even irrelevant), replaced by predictability.

Si l’on prend la promesse du big data sous l’angle de la justice, on s’aperçoit tout d’abord que règne un certain vide dans la production scientifique : si certains textes se demandent bien de quelles données parle-t-on et pour qui, nous n’en connaissons pas qui se demandent quelles normes promouvoir pour une société plus juste dans un monde mêlé d’algorithmes. Pourtant les représentations normatives du juste sont légions chez ceux qui voient dans l’ordinateur la solution technique à nombre d’impasses sociales. Là où les humains sont pris en faute, la technique ne peut-elle pas contrecarrer leurs tendances égoïstes ? C’est ainsi que contre l’opacité du recueil des données privées par les géants du net, vient se dresser le militantisme de l’ouverture totale qui conçoit la justice sociale comme émanant de la transparence universelle des « données ouvertes » (open source). Cas particulièrement bien illustrés dans le présent recueil par les contributions d’Eric Arrivé sur le protocole Bitcoin ou de Pierre Gautreau et Mathieu Noucher sur le partage des données environnementales.

If we look at the promise of big data from the perspective of justice, the first thing we see is that there is something of a scientific void: while certain texts do ask what the data are and who they are for, we know of none that ask what standards should be advocated for a more just society in a world saturated with algorithms. Yet there are myriads of normative representations of what is just amongst those who see the computer as the technical solution to many social deadlocks. When human beings are caught doing wrong, cannot technology counter their egotistical tendencies? So the opposition to the collection of private data by the giants of the web comes from the activism of total openness, which conceives social justice as emanating from the universal transparency of “open source”, cases particularly well illustrated in this collection by the contributions of Eric Arrivé on the Bitcoin protocol or of Pierre Gautreau and Mathieu Noucher on the sharing of environmental data.

Plus généralement, de l’ensemble de ce dossier, ressort une idée forte : pour une grande partie des opérateurs du monde numérique, un juste usage des données serait intrinsèquement lié à la manière dont on les élabore et on les communique. La transparence totale serait donc tout à la fois une fin et un moyen, devenant la norme du juste.

More generally, one powerful idea emerges from this issue of jssj as a whole: for many operators in the digital world, a just use of data is intrinsically linked to the way those data are prepared and communicated. From this perspective, total transparency is both an end and a means, becoming the standard of justice.

Selon les textes rassemblés ici, cette thèse est éminemment contestable. L’examen des procédures numériques concrètement mises en œuvre montre dans certains cas que l’ouverture des données peut aboutir à la reproduction des inégalités (et des injustices) déjà existantes, dans d’autres cas à la production de nouvelles formes d’injustices. La transparence est-elle alors à considérer comme bivalente ? Côté face, elle est assimilée à la vérité et à l’émancipation, chacun pouvant potentiellement devenir acteur de sa propre vie numérique. Côté pile, elle est traçabilité, fichage, bureaucratie.

According to the articles collected, in this issue this thesis is highly disputable. The examination of digital procedures as actually implemented shows in certain cases that the opening up of data can result in the reproduction of existing inequalities (and injustices), and in other cases to the production of new forms of injustice. Should transparency therefore be seen as bivalent? Heads, it is equated with truth and emancipation, with each of us potentially able to become agents of our own digital life. Tails, it is about traceability, tracking, bureaucracy.

Cette nature bivalente de l’information hantait déjà les débats politiques au tournant des années 1970, quand l’informatique centralisée (symbolisée par le géant I.B.M.) régnait encore en maître et que scientifiques et militants s’interrogeaient sur le rôle de la quantification pour la compréhension de (et l’action sur) la société. Bégaiement du débat sur lequel il est important de réfléchir quelques instants.

The bivalent character of information was already pervasive in political discussions in the early 1970s, when centralised IT (symbolised by the giant IBM) still reigned supreme and scientists and activists questioned the role of quantification in the understanding of (and action on) society. A stuttering debate which is worth examining for a moment.

Le règne du chiffre : de l'histoire ancienne ?

The reign of numbers: ancient history?

En 2011, le groupe Oblomoff écrivait : « Un demi-siècle s’est écoulé depuis les écrits de Cornelius Castoriadis ou d’Henri Lefebvre sur la bureaucratie et la technique. Des livres comme Le mouvement révolutionnaire sous le capitalisme moderne ou Position : contre les technocrates partaient du constat d’un changement de nature des sociétés capitalistes modernes, telles qu’elles se formèrent durant les années qu’on a ensuite appelé les « Trente Glorieuses » (……) Depuis, quarante années de « crise » et de néolibéralisme n’ont fait que confirmer ce constat : la gestion, autrement dit la prise en charge de nos vies par un corps séparé de technocrates est aujourd’hui archi-dominante » (Oblomoff 2011, p. 3).

In 2011, the Oblomoff group wrote: “Half a century has passed since the writings of Cornelius Castoriadis or Henri Lefebvre on bureaucracy and technology. Books like Modern Capitalism and Revolution or Position: against the technocrats began with the postulate of a change in the nature of modern capitalist societies, as they formed during the years that came to be called the “Glorious Thirty” (……) Since then, forty years of “crisis” and neoliberalism have done nothing but confirm this postulate: management, in other words the takeover of our lives by a separate corpus of technocrats is today massively in the ascendancy” (Oblomoff 2011, p.3).

Nous souhaitions d’emblée citer cet ouvrage consacré à la critique du gouvernement par les nombres, notamment parce qu’il contient le dernier texte publié d’Alain Desrosières, peu de temps avant sa mort. Alain Desrosières qui en tant qu’administrateur de l’INSEE a vécu quatre décennies d’inflation de la quantification assistée par la révolution numérique et a cherché à en faire l’histoire critique[2]. Dans ce dernier texte (en fait une retranscription de conférence et du débat qui l’a suivi), il revenait sur les distinctions qu’il opérait entre l’Etat ingénieur, qui, de Colbert à l’Union soviétique s’occupait de compter des quantités physiques, l’Etat libéral qui prétendait se passer de quantification puisque toute l’information est contenue dans les prix, l’Etat providence qui développait la quantification dans une logique assurantielle, l’Etat keynesien qui se préoccupait de gérer sous forme d’agrégats des flux macro-économiques dans le cadre de la comptabilité nationale, et enfin l’Etat néolibéral, le plus difficile à analyser puisque le plus récent. Desrosières s’accordait toutefois avec Vincent de Gaulejac pour comprendre cet État néolibéral comme contemporain de l’inflation des procédures de quantifications héritées du management privé (Gaulejac 2005). Desrosières insistait sur la diversité des rapports du pouvoir politique à la gestion par les quantités, il insistait sur les chevauchements, les hybridations de ces différents rapports, mais il insistait bien aussi sur la croissance exponentielle de ce gouvernement par les nombres. Un gouvernement rendu à la fois nécessaire par le changement d’échelle de l’intervention humaine sur la planète, mais aussi rendu possible par la révolution contemporaine de l’outillage numérique et de la masse de données qu’il produit, masse désormais immédiatement disponible et traitable par l'ordinateur.

One reason why we wanted to begin by quoting this volume dedicated to the critique of government by numbers, was because it contains the final text published by Alain Desrosières, shortly before his death. Alain Desrosières who, as administrator of INSEE, had experienced four decades of quantificatory inflation assisted by the digital revolution, and aspired to produce a critical history of the phenomenon.[2] In this final text (in fact the transcription of a lecture and the debate that followed it), he returned to the distinctions he drew between the Engineering State which, from Colbert to the Soviet Union, was concerned with counting physical quantities, the Liberal State which claimed to do without quantification since all information is contained in market prices, the Welfare State which developed quantification for insurance purposes, the Keynesian State which was interested in managing aggregate macroeconomic flows for the purposes of national accounting, and finally, the Neoliberal State, the most difficult to analyse because the most recent. Desrosières nonetheless agreed with Vincent de Gaulejac in understanding this Neoliberal State as contemporary with the inflation of quantification procedures inherited from private sector management (Gaulejac 2005). Desrosières stressed the diversity of the relations between political power and management by quantities, as well as the overlaps and hybridisations between these different relations, but he also emphasised the exponential growth in government by numbers. Government both made necessary by the change in the scale of human intervention on the planet, and also made possible by the contemporary revolution in digital tools and by the mass of data they produce, a mass now immediately available for computer processing.

Face au déferlement des chiffres et des données, le champ académique des Sciences Humaines et Sociales est profondément bouleversé. Il serait impossible de citer ici les différentes réactions à ce nouvel ordre du chiffre, même en s’en tenant à une seule tradition disciplinaire. Mais, plus généralement, le débat scientifique discute bien aujourd’hui l'idée qu'avec l'avènement du Big Data[3] et des capacités toujours croissantes de traiter ces données, un nouveau monde s'ouvre à la connaissance, laquelle sera dès lors plus précise, plus exacte, bref, plus « vraie » dans la tentative de compréhension du monde.

The flood of numbers and data has brought about an upheaval in the academic field of Humanities and Social Sciences. It would be impossible to cite here the different reactions to this new statistical order, even sticking to a single disciplinary tradition. More generally, however, there is no doubt that the scientific debate today focuses on the idea that with the emergence of Big Data[3] and ever-growing capacity to process those data, a new world of science is opening up, which will now be more accurate, more precise, in short more “true”, in the attempt to understand the world.

Ce postulat ne va toutefois pas de soi et se trouve largement contesté par de nombreuses voix émanant des SHS. On peut par exemple citer Richard Shearmur, géographe canadien défendant en 2015 la supériorité du recensement de la population sur le Big Data comme outil de compréhension du monde social : « A brave new world is upon us: more data and more computing capacity are going to reveal all and solve our problems, hubris reminiscent of the post-war cyberneticists (...), data-driven regional scientists of the 1960s and some GIS analysts of the 1990s.” (Shearmur, 2015 : 965). Là encore, il semble que l'histoire de la quantification se répète : Desrosières avait de manière similaire largement exposé les choix méthodologiques qui ont abouti dans les années 1970 à la popularisation de la représentation de la société française en groupes organisés selon les axes principaux d’une analyse en composantes principales, à l'époque considérée comme révolutionnaire.

However, this postulate is not self-evident, and is strongly contested by numerous voices within the Humanities and Social Sciences. One example is the Canadian geographer Richard Shearmur, who in 2015 argued the superiority of the population census over Big Data as a tool for understanding the social world: “A brave new world is upon us: more data and more computing capacity are going to reveal all and solve our problems, hubris reminiscent of the post-war cyberneticists (…), data-driven regional scientists of the 1960s and some GIS analysts of the 1990s.” (Shearmur, 2015 : 965). Here again, it would seem that the history of quantification is repeating itself: Desrosières had similarly widely publicised the methodological choices that in the 1970s led to the French society being represented in terms of groups structured along the main axes of a breakdown into primary components, an approach perceived at the time as revolutionary.

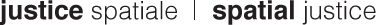

Figure 1 : L’analyse en composantes principales

Figure 1 : Principal components analysis

Source : « le prix d’un français » in Le nouvel observateur du 22 septembre 1975.

Source : « le prix d’un français » in Le nouvel observateur du 22 septembre 1975.

Cette figuration d’une analyse statistique des correspondances a été publiée en 1975 par le Nouvel Observateur à partir des données de la statistique publique. Analyse des correspondances dont Desrosières note qu’elle était alors considérée comme purement descriptive, sans théorie sous-jacente, et d’autre part parce que « multidimensionnelle », elle semblait, dans le sillage de 1968, comme un gage de pluralisme, ouvrant la voie à une représentation de la société plus ouverte et plus libre que la simple logique « classe contre classe » (Desrosières 2008b).

This representation of a statistical analysis of correspondences was published in 1975 by the Nouvel Observateur magazine using public statistical data. It was an analysis of which Desrosières noted that it was considered at the time as purely descriptive, with no underlying theory, and also that – because it was “multidimensional” – it seemed in the wake of the events of 1968 to be a guarantee of pluralism, opening the door to a more open and freeer representation of society than the simple logic of “class against class” (Desrosières 2008b).

C’est ce type d’analyses et de représentations graphiques que Pierre Bourdieu a utilisé dans des ouvrages majeurs comme par exemple La Distinction (Bourdieu 1979), pour prouver la validité de ses théories sur le champ social et le moteur des pratiques que constitue l’habitus… Si l’on suit toujours Desrosières, en manipulant les statistiques multivariées issues d’enquêtes ou des données de l’INSEE, Bourdieu pensait se soustraire à toute accusation de pré-catégorisation tendancieuse… D’une certaine manière, et en dépit de ses longues analyses critiques de l’usage du chiffre en Sciences Sociales, il croyait ou laissait croire que bien utilisés, les chiffres parlaient d’eux même … C'est évidemment une idée que l’on retrouve aujourd’hui, à peine actualisée, dans bien des débats sur la donnée extraite grâces aux pratiques de data mining ou de profilage propres au Big Data. Pour citer à nouveau Shearmur, c'est bien le rêve positiviste de Laplace qui sous-tend aujourd'hui toutes les affirmations de supériorité du Big Data par rapport aux formes plus traditionnelles de production de données : « The Big Data vision takes us right back to Laplace’s positivistic demon, the imaginary—but now, we are told, realisable—entity which, armed with perfect information, will be able to predict the future, taking all humanness, imperfection and doubt out of our lives.” (Shearmur, 2015 : 965).

It is analyses and graphic representations of this kind that Pierre Bourdieu used in his major works, such as, La Distinction (Bourdieu 1979) to prove the validity of his theories about the social sphere and of habitus as a driver of practices… Still according to Desrosières, by manipulating multivariate statistics drawn from INSEE surveys or data, Bourdieu thought that he could avoid being accused of tendentious pre-categorisation… In a way, and despite his long critical analyses of the use of quantities in Social Sciences, he believed or implied that, if properly used, numbers speak for themselves… This is obviously an idea that we are seeing again today, almost unchanged, in many debates on data extracted through the data mining or profiling methods specific to Big Data. To quote Shearmur again, it is undoubtedly the positivist dream that today underlies all Big Data’s claims of superiority to more traditional forms of data production: “The Big Data vision takes us right back to Laplace’s positivistic demon, the imaginary—but now, we are told, realisable—entity which, armed with perfect information, will be able to predict the future, taking all humanness, imperfection and doubt out of our lives.” (Shearmur, 2015 : 965).

Le numérique au coeur des questions de liberté et d’égalité

Digital technology key to questions of liberty and equality

Desrosières constatait dès les années 1970 que les illustrations graphiques de l’analyse des correspondances dressant le portrait de la société française donnaient à peu près le même résultat, tant dans le Nouvel Observateur que chez les professionnels du marketing et que chez Pierre Bourdieu. On y retrouvait un axe vertical permettant de différencier les groupes essentiellement en fonction du revenu… c’est un axe que nous pourrions appeler axe de l’égalité ou de l’inégalité. Le deuxième axe, horizontal paraissait alors plus novateur : c’est celui qui émergeait du traitement statistique multivarié. Il reposait essentiellement sur la diversité des relations au travail, avec d’un côté un monde plutôt urbain, salarié, attaché à la fonction publique, et de l’autre un monde plus rural, peuplé de professions libérales, de petits et grands patrons et d’agriculteurs. D’un côté donc, ceux qui doivent compter pour s’élever sur les diplômes délivrés par les macro-structures de la reproduction sociale encadrée par l’Etat (nous voulons dire : l’école), et de l’autre ceux qui pensent pouvoir ou devoir compter sur le capital économique familial pour s’élever.

Back in the 1970s, Desrosières observed that the graphs illustrating the correspondences used to depict French society gave roughly the same result, whether in the Nouvel Observateur, amongst marketing professionals or with Pierre Bourdieu. There was a vertical axis which differentiated the groups essentially on the basis of income… which we could call the axis of equality or inequality. The second – horizontal – axis, based on multivariate statistical analysis, appeared more innovative at the time. It essentially reflected the diversity of working relations, with on one side a largely urban, salaried world, associated with public sector employment, and on the other a more rural world, populated by the liberal professions, the owners of small and large businesses, and farmers. On one side, therefore, those who do get on in the world had to rely on qualifications provided by the state-managed microstructures of social reproduction (i.e. schools), and on the other those who believed that they could or must count on family economic capital in order to advance.

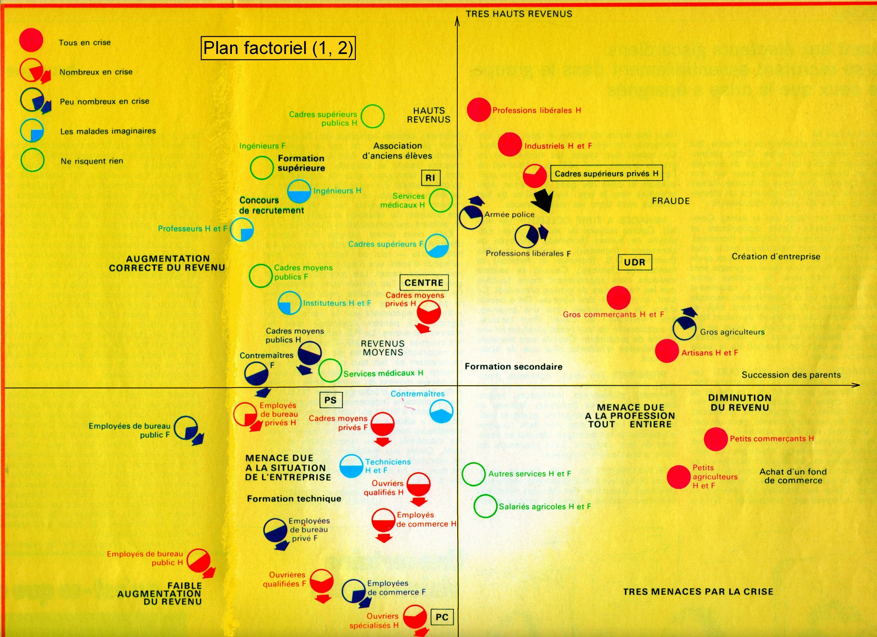

Figure 2 : L’espace social à deux dimensions vu par le dessinateur Wiaz en 1974

Figure 2 : The two dimensions of social space, as seen by Wiaz in 1974

Source : « le prix d’un français », Le Nouvel Observateur, 16 septembre 1974, p.65

Source : « le prix d’un français », Le Nouvel Observateur, 16 septembre 1974, p.65

C’est ce qu’exprime ce dessin de Wiaz paru dans le nouvel observateur en 1974…

That is the situation expressed by this drawing by Wiaz published in the Nouvel Observateur in 1974…

Si l’axe vertical est celui de l’inégalité, alors, en poussant l’analyse à peine plus loin que Desrosières, nous prendrons le risque de poser que cet autre axe, l’horizontal, est celui des diverses possibilités d'exercer une forme de liberté de mouvement au sein de la société, et donc de contrer les effets d'inégalités qu'elle produit. Ce sont ici des lectures autres des mécanismes de fonctionnement de la société qui sont proposées, grâce au chiffre, et qui articulent bien liberté et égalité.

If the vertical axis represents inequality, then – pushing the analysis only a little further than Desrosières – we will take the risk of positing that the other axis, the horizontal, represents the different possibilities of exercising a form of freedom of movement within society, and therefore of countering the inequality affects that it produces. Here, what is proposed – through numbers – are other readings of society’s operating mechanisms, which do indeed connect liberty and equality.

Il y a plus : dès les années 1970, l’outil qui avait rendu possible de retrouver ces deux éléments fondamentaux des revendications de justice était déjà lui-même pris en tension entre ces deux pôles.

There is more: even in the 1970s, the tool that had made it possible to rediscover these two fundamental elements of the claims for justice was already itself caught between these two poles.

L’informatique est en effet très tôt entrée dans le débat scientifique puis public entre critique des inégalités et critique des privations de liberté : on peut encore suivre Desrosières, à propos de l’affaire Safari qui défraya la chronique médiatique et politique en 1974 et déboucha sur la loi Informatique et libertés et la création de la Commission Nationale Informatique et Liberté (CNIL) en 1978. À l’époque, les médias et les institutions de la société civile s’étaient émues du projet d’établissement d’un identifiant unique pour chaque individu permettant de recouper les fichiers des diverses administrations publiques, en établissant ainsi une forme de « fichier des fichiers ». S’il permettait in fine de réaliser l'objectif d'une meilleure compréhension des mécanismes sociaux, il n'en était pas moins soupçonné d'aboutir à une privation insupportable des libertés fondamentales, le fichage sous toutes ses formes ne tombant jamais loin de la surveillance totalitaire des individus.

Information technology entered very early into the scientific – and then public – debate between the critique of inequalities and the critique of loss of liberty: once again, we can follow Desrosières, on the subject of the “Safari affair”, which hit the media and political headlines in 1974 and culminated in France’s Data Protection law and the creation of the National Information Technology and Freedom Commission (CNIL) in 1978. At the time, the media and civil society institutions were hot under the collar about the plan for the establishment of a single identifier for every individual, which would cut across the records of the different public administrations, thereby establishing a sort of “file of files”. While it ultimately made possible the goal of achieving a better understanding of social mechanisms, it was nevertheless suspected of leading to an intolerable loss of fundamental liberties, since there was a perceived link between all forms of record-keeping and the totalitarian surveillance of individuals.

De fait, Desrosières a noté que le personnel politique et médiatique était alors tombé à bras raccourcis sur le ministère de l’Intérieur et sur les services de police accusés d’établir les bases d’un système liberticide… Or, administrateur à l’INSEE et en charge de la partie technique de l’affaire, il était bien placé pour savoir que c’était en fait le ministère des Finances et la Direction Générale des Impôts qui étaient à la manœuvre et non pas les services de police. Dans un objectif de justice fiscale, il s’agissait pour les services fiscaux d’empêcher les plus riches de déclarer revenus et patrimoines de manière éclatée dans différents départements. C’est donc au nom de l’égalité qu’on prenait ainsi certains risques en termes de libertés… Plus simplement, comme Desrosières l’a exprimé : « Ouf, c’est sur les flics que c’est tombé !» (Desrosières in Oblomoff 2011)…

In fact, Desrosières noted that politicians and the media lashed out at the Ministry of the Interior and the police services, accusing them of laying the foundations for the elimination of basic freedoms… However, as an administrator at INSEE and the man responsible for the technical aspect of the affair, he was well placed to know that the main players here were in fact the Ministry of Finance and the Tax Authority, not the police services. For reasons of fiscal justice, the tax services were trying to prevent the rich from declaring income and assets in a fragmented way with different departments. In other words, certain risks were being taken with liberty for the sake of greater equality… More simply, as Desrosières put it: “ Phew! It was the cops who got it in the neck” (Desrosières, in Oblomoff 2011)…

L’affaire est donc là aussi ancienne, et cette ancienneté pose bien sûr problème : quoi de neuf alors avec la déferlante informatique apportée par le Big Data ? Ne s'agit-il que d'un bégaiement du débat et si tel est le cas, comment l'expliquer ? Qu’est-ce qui distingue finalement une critique de la quantification d’une critique de l’informatisation ?

So here again, it is old news, which of course raises a problem: what is new about the wave of IT that comes with Big Data? Is it just another stutter in the debate, and if so how can it be explained? Ultimately, what distinguishes a critique of quantification from a critique of computerisation?

C’est la question à laquelle s’attelle par exemple Antoinette Rouvroy à propos de ce renouveau digital du « gouvernement par les nombres », qu’elle appelle, suivant une analyse foucaldienne, « gouvernementalité algorithmique » (Rouvroy, Berns 2013). Nous résumerons son argument ainsi : ce n’est pas ou plus l’individu, le sujet politique, juridique ou philosophique qui est visé par les méthodes modernes de quantification et notamment par l'exploration de données. Il n’y a pas d’attentat revendiqué et conscient contre les libertés individuelles. Il n’y a pas d’Etat oppresseur, pas de big brother orwellien ni de little sisters[4] dans ce Meilleur des mondes. Personne, nous dit Rouvroy, n’est occupé à nous espionner personnellement… Il y a bien plutôt la nécessité de gérer des flux, des trajectoires et des performances dans un monde vécu, perçu et conçu comme de plus en plus liquide et rapide et pour lequel la quantification et la mesure de la performance s'imposent comme centrales, dans un but d'optimisation perpétuelle des systèmes. Face à cette nécessité gestionnaire, ce n’est pas l’individu qui intéresse, mais son profil d'usager sans cesse recomposable à partir des données qu’il produit ou que des automates (smart phones, etc.) produisent grâce à diverses formes de captures numériques.

That is the question pursued, for example, by Antoinette Rouvroy, with regard to this digital revival of “government by numbers”, which she calls, from the perspective of a Foucauldian analysis, “algorithmic governmentality” (Rouvroy, Berns 2013). We will sum up her argument as follows: it is not or it is no longer the individual, the political, legal or philosophical subject, who is the target of modern methods of quantification and notably of data mining. There is no overt and conscious attack on individual liberties. There is no oppressive state, no Orwellian big brother or little sisters in this Brave New world[4]. No one, Rouvroy tells us, is occupied in spying on us personally… Rather, the need is to manage flows, trajectories and performances in a world experienced, perceived and conceived as increasingly fluid and fast moving, in which quantification and performance measurement have become central for the purpose of perpetually optimising systems. In light of this managerial necessity, it is not individuals who are interesting, but their profiles as users who can be constantly reconstructed through the data they produce or that machines (smart phones, etc.) produce by means of various forms of digital capture.

Qu’en est-il alors aujourd’hui de cette ancienne volonté de cloisonner les fichiers – rebaptisés bases de données - alors que nous laissons constamment des traces, des données informatiques en nombre incalculable, recoupées sans aucun scrupules par une myriade d’institutions publiques et privées, basées sur le territoire national ou à l’étranger, et alors que les institutions de type CNIL s’avouent d’elles même complétement dépassées par les événements ? Mais aussi alors que l’interopérabilité des systèmes et l’ouverture des données les plus « brutes » possibles au public deviennent des valeurs en soi… au nom par exemple d’un usage partagé et démocratique, voire au nom d’un empowerment de la société civile, qui induisent la transparence et l'ouverture de ces mêmes données ?

What has happened today to that old desire to compartmentalise files – now called databases – when we constantly leave traces, an incalculable volume of computer data, accessed without the slightest scruple by a myriad of institutions, public and private, domestic and foreign, and at a time when institutions like the data protection authority (CNIL) acknowledge themselves completely overtaken by events? But also when the interoperability of systems and the opening of the “rawest” possible data to the public are becoming values in their own right… on the grounds, for example, of shared and democratic use, or even the empowerment of civil society, which call for those data to be transparent and open.

Par son usage du terme de gouvernementalité, Antoinette Rouvroy nous amène donc aussi à penser la décentralisation des pouvoirs, pouvoirs dont le but n’est pas de discipliner les foules mais d’agir sur leur comportement et sous leur niveau de conscience, par des modifications de leur environnement. Elle nous dit que ces pouvoirs sont aujourd’hui confiés à des algorithmes plus ou moins « auto-apprenants » ou « auto-correcteurs » qui décryptent ces flux et ces mouvements, les discrétisent, les corrèlent pour ensuite influer sur les conduites… ce dont nous ne nous rendons compte le plus souvent quand nous surfons sur le web et que nous arrive une publicité pour des poussettes après avoir consulté un site sur les biberons. Mais ces algorithmes, en fait, gouvernent des secteurs entiers de la vie comme les transactions boursières analysées par Alexandre Laumonnier (Laumonnier 2013) , comme la fréquence des rames de métro étudiées par Julien Mattern (Mattern, 2011), ou comme la gestion des stocks des plateformes logistiques analysées par David Gaborieau (Gaborieau, 2012).

By her use of the term governmentality, Antoinette Rouvroy also prompts us to think about the decentralisation of powers, powers intended not to discipline the masses but to act on their behaviour and on their level of awareness, through modifications to their environment. She tells us that these powers are now assigned to algorithms with varying capacities for “self-teaching” or “self-correcting”, which decipher, discretise and correlate these flows and movements, in order subsequently to influence behaviours… of which we usually become aware when we are surfing the web and come across an advertisement for buggies after accessing a website on baby bottles. But these algorithms in fact govern entire sectors of life, like the stock market transactions analysed by Alexandre Laumonnier (Laumonnier 2013), the frequency of subway trains studied by Julien Mattern (Mattern 2011), or the stock management on logistics platforms analysed by David Gaborieau (Gaborieau 2012).

Au final, on retrouve aussi le vieux débat sur le chiffre comme outil de la purification du processus de recherche scientifique lui-même. Défenseur de la statistique publique parce qu’initiatrice de débats publics, Desrosières doit se retourner dans sa tombe. Jamais le chiffre n’a été conçu comme aussi vrai, aussi pur, aussi débarrassé de fausses causalités. Il ne prétend plus opérer que par corrélations et se passe donc très bien des aspects théoriques ou philosophiques qui justifiaient leur utilisation par des chercheurs comme Pierre Bourdieu. C’est là un des éléments essentiels du débat contemporain sur le chiffre, quand des scientifiques comme Alex Pentland, informaticien et fondateur du Laboratoire de Dynamiques Humaines (Human Dynamics Lab) du MIT, posent le Big Data comme une véritable révolution copernicienne par sa capacité à libérer les Sciences Humaines de la recherche des causalités. (Pentland, 2014). Bégaiement toujour ?

Ultimately, we also come back to the old debate on numbers as a tool for the purification of the scientific research process itself. As an advocate of public statistics as a means of stimulating public debate, Desrosières must be turning in his grave. Never have figures been seen as so true, so pure, so devoid of false causalities. They no longer claim to operate otherwise than by correlations and are therefore quite content to do without the theoretical or philosophical aspects that scholars like Pierre Bourdieu cited to justify their use. This is one of the essential elements of the contemporary debate on number, when people like the computer scientist Alex Pentland, founder of MIT’s Human Dynamics Lab, promote Big Data as a true Copernican revolution in its capacity to liberate the Human and Social Sciences from the quest for causalities. (Pentland 2014). A stuttering debate, all over again?

La justice spatiale, entre addiction au chiffre et critique de la quantification

Spatial justice, between addiction to figures and critique of quantification

D'une manière générale, en articulant la question de la justice sociale avec l’espace, les porteurs de revendications pour plus de justice spatiale passent nécessairement par un certain nombre d'étapes :

Broadly speaking, by connecting the issue of social justice with the spatial sphere, those calling for greater spatial justice necessarily go through a number of stages:

À ces différentes étapes (et singulièrement au cours de la première et de la dernière), toutes les revendications pour plus de justice (spatiale comme sociale) s'appuient sur des données quantifiables, permettant de définir et de saisir les inégalités pour, au besoin, en proposer une correction. Ceci exige des indicateurs toujours plus fins, plus fiables, plus récents, et exige aussi les moyens intellectuels de les interpréter. Les revendications pour plus de justice spatiale se mettent donc « à la mesure » de l'économie de la donnée et, bien souvent, ne peuvent plus se légitimer sans passer par un stade algorithmique d’élaboration, de recueil et de traitement des indicateurs au sein des ordinateurs. Ceci pose en soi deux grandes questions :

At these different stages (and singularly during the first and last), all the calls for greater justice (both spatial and social) rely on quantifiable data that can be used to define and grasp inequalities and, where necessary, to propose corrections. This demands the most refined, reliable and recent indicators, and also the intellectual resources to interpret them. Claims for greater spatial justice are therefore placed “on the same scale” as the data economy and, in many cases, can no longer be legitimised without going through an algorithmic phase in which the indicators are developed, collected and processed by computers. In itself, this raises two major questions:

1/ Faut-il uniquement prendre acte de ce nouveau monde numérique et s’y insérer ? En ce cas, il est fort à parier qu'on retrouvera alors les vieux débats des années 1970 que nous venons d’évoquer, ceux qui étaient menés au nom de l’égalité ou ceux qui étaient menés au nom de la liberté.

1/ Should we simply acknowledge this new digital world and join in? In that case, the chances are high that there will be a return to the old debates of the 1970s described above, whether conducted on the grounds of equality or of liberty.

Le retour aux années 1970 est là encore riche d'enseignements. Marion Tillous (Tillous 2009) a montré comment le sociologue Jean-François Augoyard a été amené à analyser les déplacements quotidiens des habitants d’un grand ensemble grenoblois « l’Arlequin », construit à l’occasion des jeux olympiques de 1968, dans une optique urbanistique fonctionnaliste inspirée de Le Corbusier. Un grand ensemble dont elle nous dit qu’il avait été particulièrement bien pensé et réalisé, évitant par exemple le piège du monofonctionnalisme. Or les habitants semblaient ne pas se déplacer de la manière prévue, malgré le nombre et la qualité des enquêtes sociales préalables. À partir de centaines d’entretiens et d’une immersion prolongée dans le quartier, Augoyard arrivait à la conclusion suivante : un déplacement ne se réduit pas à un couple origine – destination. Une analyse fine permet au contraire de percevoir que les habitants en se déplaçant, inventent une langue silencieuse, poétique, formée sur la répétition rythmée de figures de styles telles que l’ellipse, la redondance… quelque chose qui rappelle furieusement les expériences artistiques des situationnistes des années 50 quand ils pratiquaient la « dérive » urbaine. C’est ce travail d’Augoyard que Michel de Certeau (de Certeau 1990) a réutilisé pour définir les « tactiques » individuelles, irréductibles aux « stratégies » des décideurs, coincés dans une vision cartographique forcément surplombante et donc lointaine. On semblait donc avec Augoyard et de Certeau pouvoir faire confiance à l’irréductible autonomie des individus, toujours libres de construire leur propre récit spatial… On était là aux origines de la géographie des individus, et d’une alter-cartographie des émotions, des sensations. Or là encore, avec quarante ans de recul, quel étrange constat que celui de voir ce libre récit spatial saisi par les traces numériques de nos smartphones, par les écrans publicitaires numériques qui observent ce que nos yeux regardent pour nous proposer la publicité qu’il faut là où il faut, et de plus en plus, par un « internet des objets » qui étend à tous les domaines de la vie la logique de la traçabilité industrielle.

Here again, there is much we can learn from the 1970s. Marion Tillous (Tillous 2009) has shown how the sociologist Jean-François Augoyard was prompted to analyse the day-to-day travel patterns of the inhabitants of the “Arlequin”, a large housing estate in Grenoble built for the 1968 Olympic Games to a functionalist urban design inspired by Le Corbusier. An estate that she describes as having been particularly well designed and built, for example in avoiding the trap of monofunctionalism. However, the inhabitants did not seem to move around in the predicted way, despite the number and quality of the preliminary social surveys. On the basis of hundreds of interviews and prolonged immersion in the district, Augoyard reached the following conclusion: a journey cannot be reduced to an origin/destination pairing. In fact, a close analysis shows that, as they move around, the inhabitants devise a silent, poetic language, formed from the rhythmic repetition of stylistic devices such as the ellipse, redundancy… something that strongly recalls the artistic experiments of the situationists in the 1950s, in the practice of urban “dérive” (drifting). It is Augoyard’s work here that De Certeau reused to define individual “tactics” that are irreducible to the “strategies” employed by decision-makers, confined as they are to a mapmaker’s view that is inevitably top-down and therefore remote(de Certeau 1990). It therefore seemed possible, with Augoyard and De Certeau, to rely on the irreducible autonomy of individuals and their freedom to construct their own spatial narrative… This was the start of the geography of individuals and a different cartography, of emotions, of sensations. But here again, forty years on, how strange it is to see this free spatial narrative captured by the digital traces of our smartphones, by digital advertising screens that observe the direction of our gaze in order to propose the right advertisement in the right place and, increasingly, by an “Internet of things” which is extending the logic of industrial traceability into all spheres of life.

Ce qui était opaque est-il condamné à devenir transparent, et si oui, pour qui ?

Is what was once opaque condemned to become transparent and, if so, for whom?

La recherche de justice peut dès lors se contenter de prendre acte et de chercher à utiliser ces informations pour mieux décrire, et revendiquer même la multiplication des capteurs dans ce sens. Pour prendre un exemple cité par Elisabeth Tovar dans sa contribution au présent dossier, les données géolocalisées des smartphones forment une excellente base de données pour étudier les ségrégations urbaines diurnes, et donc affiner largement notre perception des ségrégations mesurées par le lieu d’habitat, c’est-à-dire par l’endroit où l’on dort. C’est aussi ce que peuvent inspirer les travaux d’Amandine Chapuis (Chapuis 2012) par exemple, qui piste les « traces » numériques des touristes à Amsterdam et explique leurs pratiques de la ville ainsi mises à nu par leur profil social et culturel. Utiliser ainsi les données numériques, ce peut être un bel outil de quantification au service de plus de justice, quand quantifier une discrimination permet de la mettre en évidence et de la fonder en vérité, et quand quantifier une perte permet de la même manière de quantifier une compensation.

In that case, the quest for justice can be content to acknowledge and seek to use this information for the purposes of better description, and even to call for more sensors to that end. To take an example cited by Elisabeth Tovar in her contribution to this feature, the GPS data on smartphones provide an excellent database for the study of daytime urban segregations, and the possibility of significant refinements to our perception of segregation as measured by residential location, i.e. the place where people sleep. Further inspiration can come from the work of Amandine Chapuis (Chapuis 2012), for example, who follows the digital “tracks” of tourists in Amsterdam and explains the urban practices thus revealed by their social and cultural profile. Used in this way, digital data can be a good tool for enhancing justice through quantification, which can highlight and demonstrate discrimination, just as quantifying a loss is a way to quantify compensation.

Il est donc tentant de voir dans le Big Data un formidable outil augmenté de décryptage – et donc de dépassement - des inégalités, et cette proposition suit d'ailleurs une tendance qui s’exprime de manière plus évidente chez certains auteurs, notamment féministes (Haraway 1991, Braidotti 2013), pour lesquels le cyborg post-humain représente la seule figure du dépassement des inégalités les plus profondes, telles que les inégalités hommes-femmes. Qu’ont à dire sur le sujet ceux qui, défendant l’open data et l’open source, croient (encore) à une subversion des dominations par l’usage partagé des données numériques ? Que dire encore des politiques qui se jugent de plus en plus selon des méthodologies de calcul complexes, pour évaluer l’efficacité d’actions, notamment sociales ou médicales, sur des territoires-test[5]? Que reste-il enfin des tentatives d’institution d’une justice « par le bas » largement appuyée sur le partage des données, face à des formes de contrôle, plus cybernétiques que policiers, plus diffus, plus décentralisés, menés dans une fiction de temps réel, mais qui n’en demeurent pas moins résolument « par le haut »… du haut vers le bas, alors même qu’ils sont menés au nom de la réticularité, du lien, du flux, de la transparence d’un univers où la liquidité fait figure de valeur économique, politique, et morale (Boltanski, Chiapello 1999 ; Bonneuil 2015) ?

It is therefore tempting to see Big Data as a powerful tool for deciphering – and therefore overcoming – inequalities, and this proposal in fact follows the trend expressed more explicitly by certain authors, in particular feminists (Haraway 1991, Braidotti 2013), for whom the post-human cyborg represents the only way to overcome the most deep-seated inequalities, such as those between men and women. What is the view of those who – in advocating open data and open source – still believe in the subversion of domination by the shared use of digital data? What is to be said about policies that are increasingly judged on the basis of complex computation methods, to evaluate the effectiveness of actions – in particular social or medical measures – on pilot territories?[5] And finally, what remains of the attempts to introduce a “bottom-up” justice, largely reliant on the sharing of data, in the face of forms of control that are more about cybernetics than policing, more diffuse, more decentralised, conducted in a fictional real-time, but nevertheless resolutely “top-down”, despite being pursued on grounds of reticularity, of linkage, of flow, of the transparency of a universe in which fluidity is perceived as an economic, political and moral value (Boltanski, Chiapello 1999 ; Bonneuil 2015)?

2/ Rechercher la justice spatiale nécessite-t-il au contraire d’aller au-delà de ce rattrapage et de se lancer dans une analyse critique de la production du chiffre et de l’algorithme ? Ne faut-il pas plutôt s'attacher à comprendre la logique de l’inflation numérique ? C’est la question qui se pose à chaque fois que nous nous demandons si tout est mesurable et si tout doit être mesuré, à chaque fois que nous constatons que l’approche quantitative du monde laisse toujours sur le carreau un reste, un oubli, condamné à n’être plus qu’un fantôme statistique, quelle que soit la finesse sans cesse augmentée des indicateurs.

2/ Does the quest for spatial justice instead require us to go beyond this appropriation and to undertake a critical analysis of the production of figures and algorithms? Should we not rather seek to understand the logic of digital inflation? It is the question that arises each time we wonder whether everything is measurable and whether everything should be measured, every time we realise that the quantitative approach to the world always leaves something behind, something forgotten, something condemned to be no more than a statistical phantom, regardless of the constantly growing refinement of the indicators.

On pourrait alors se demander ce que les algorithmes font à notre monde pour faire la géographie de ces restes et de ces écarts non retranscrits en langage binaire. Sans doute est-ce ce que Nancy Fraser avait en tête quand elle évoquait un principe de justice comme « reconnaissance » (Fraser, 2004) : reconnaitre l’existence. La logique du chiffre pousse de fait à effacer, par un rattrapage infini, les inégalités numériques. Pour le cas strictement hexagonal, c’est précisément sur ce terrain du rattrapage des inégalités d'accès au réseau que fut développée par les pouvoirs publics l'expression de « fracture numérique » : le rapport dit Attali de 2008 (Attali, 2008), en réalité Rapport de la Commission pour la libération de la croissance française, voyait toutefois dans ces inégalités d’accès plus un problème d'inefficacité économique que de justice sociale... On pourrait bien sûr aujourd’hui encore décliner cette thématique de la fracture numérique à différentes échelles (entre Nords et Suds, entre types de territoires à l'intérieur d'un même cadre national, etc.) en interrogeant à chaque fois les motivations de sa mise en évidence.

We could then wonder what algorithms are doing to our world, carry out the geography of these residues and lacunae that have not been transcribed into binary language. This is probably what was in Nancy Fraser’s mind in referring to a principle of justice as “recognition” (Fraser, 2004) : recognising existence. In fact, the logic of figures seeks, by an infinite process of catch-up, to erase digital inequalities. To take the French example, it is precisely on this terrain of overcoming inequalities in access to the network that the authorities developed the expression “digital divide”: the so-called Attali report of 2008 (Attali, 2008), in reality Report of the Committee for the Release of French Growth, nevertheless saw these inequalities of access more as a problem of economic inefficiencies than one of social justice… Of course, today this theme of the digital divide could be applied at different scales (between Norths and Souths, between types of territory within a single national framework, etc.) while each time questioning the motives for exposing it.

Réfléchir en termes de justice spatiale au chiffre peut aussi signifier choisir d’explorer cette voie des territoires, et de s’intéresser à la redéfinition des espaces par le numérique, ce que Martin Dodge et Rob Kitchin appellent coded-spaces, space-code et code-space afin de distinguer des niveaux de dépendance des lieux vis-à-vis du numérique (Dodge et Kitchin 2005, Dodge, Kitchin et Zook 2009, Kichin et Dodge 2011). Elle peut aussi s’intéresser à ceux qui réclament une locational intimacy, c'est à dire le droit à ne pas être géolocalisable (Desbois 2012), qui peut aller pour certains de ses militants jusqu'à l'adoption d’une démarche volontaire de sortie de réseau par renoncement à l'accès à internet voire même par déménagement vers une « zone blanche » peu ou mal couverte par le réseau...

Thinking about figures in terms of spatial justice can also mean exploring this territorial aspect, and investigating the way spaces are redefined by digital technology, what Martin Dodge and Rob Kitchin call coded-spaces, space-code and code-space, in order to distinguish between the levels of dependency on digital technology in different places (Dodge et Kitchin 2005, Dodge, Kitchin et Zook 2009, Kichin et Dodge 2011). It can also mean looking to those who call for locational intimacy, in other words the right not to be geolocalizable (Desbois 2012), which prompts certain activists to go deliberately off-grid by giving up Internet access, or even to move to a “dead zone” with little or no network coverage…

Que recouvre finalement cette obsession de la circulation doublée de l’obsession de la trace et de la transparence, comme si nos sociétés étaient agitées d’un mouvement brownien de plus en plus rapide exigeant des tuyaux pour la canaliser… Peut-on finalement demander à des tuyaux d’être justes ?

Finally, what is meant by this obsession with flow, combined with the obsession with tracing and transparency, as if our societies were being shaken by an ever faster Brownian motion, requiring pipes to channel it… In the end, can we demand justice from pipes?

Cinq textes originaux pour explorer ces liens

Five original texts exploring these links

D’une manière plus ou moins articulée, c’est bien l’ensemble de ces questions que la journée d’études « Liberté- Egalité-Computer : gouvernementalité algorithmique et justice spatiale » organisée en novembre 2014 souhaitait explorer. Cette journée inaugurait en parallèle une nouvelle manière de procéder pour la revue justice spatiale/spatial justice, liant séminaires et numéros thématiques. Deux ans plus tard, les cinq textes présentés dans ce numéro sont pour partie issus de cette journée d’étude, et pour partie le produit d’un appel à contributions ouvert sur le sujet.

Broadly, it is this set of questions that the day seminar on “Liberty-Equality-IT: algorithmic governmentality and spatial justice”, held in November 2014, sought to explore. That day was also the beginning of a new way of doing things for the journal justice spatiale/spatial justice, linking seminars and themed issues of the journal. Two years later, the five texts presented in this number partly originated in that seminar, and partly in an open call for contributions on the subject.

Dans le premier article, Elisabeth Tovar s’interroge sur les effets de la révolution du Big Data sur les sciences sociales et plus particulièrement sur le traitement de la question de la justice socio-spatiale par la science économique. Elle oppose l’ancien monde de la production de données centralisé, hiérarchisé et déductif (dont l’archétype serait par exemple le recensement de la population) au nouveau monde du Big Data décentralisé et inductif, et les évalue du point de vue de deux types d’approches de la justice : l’approche conséquentialiste et l’approche procédurale, faisant rejouer l’opposition largement débattue entre primatie de la liberté ou de l’égalité. L’auteure estime que le Big Data modifie et accroit notre capacité à mesurer la réalité à travers les traces numériques des activités humaines, et donc à évaluer le juste. Elle considère que cela reste un outil statistique, et donc une construction sociale, balayant les critiques qui s’insurgent contre sa dimension prédictive et ses potentielles dérives. L’enjeu est selon elle avant tout de réguler la production, la répartition et l’utilisation des données qui doivent être considérées comme des biens publics.

In the first article, Elisabeth Tovar explores the effects of the Big Data revolution on the social sciences and more specifically on how the science of economics handles the question of socio-spatial justice. She contrasts the old, centralised, hierarchical and deductive world of data production (exemplified by the population census) with the new, decentralised and inductive world of Big Data, and assesses them from the perspective of two types of approach to justice: the consequentialist approach and the procedural approach, replaying the widely debated opposition between the primacy of liberty or of equality. The author considers that Big Data alters and increases our capacity to measure reality through the digital traces of human activities, and therefore to assess what is just. She takes the view that it remains a statistical tool, and therefore a social construct, sweeping aside the critiques directed against its predictive dimension and potential excesses. For her, the challenge is primarily to regulate the production, distribution and use of data, which should be considered as a public good.

La « révolution » du Big Data ne serait en fait qu’un phénomène marginal qui, d’une certaine manière, ne ferait que reposer avec acuité l’éternelle question de l’articulation des méthodes quantitatives et qualitatives en sciences sociales.

In this view, the Big Data “revolution” is only a marginal phenomenon which, in a way, does no more than sharply restate the eternal question of the connection between quantitative and qualitative methods in the social sciences.

Après cette réflexion d’ordre épistémologique, deux études de cas se penchent sur la manière dont les outils numériques contribuent à produire et à façonner des politiques publiques, donnant à voir, parfois en creux, les rationalités gouvernementales qui sont à l’œuvre dans différents contextes.

After this epistemological perspective, two case studies explore the way in which digital tools contribute to the production and moulding of public policies, revealing – sometimes implicitly – the governmental rationalities at work in different contexts.

Leila Frouillou aborde, à travers l’analyse du programme Admission Post-Bac (APB), la mobilisation d’un algorithme comme outil de gouvernement. Considérant ce système d’affectation des publics scolaires comme une forme de gestion prédictive des conduites des élèves, elle s’intéresse à la manière dont les algorithmes « contribuent à « perfomer le monde social » ». Analysant les pratiques réelles des lycéens dans leurs usages d’APB, elle montre que celui-ci est un puissant outil de reproduction des inégalités socio-spatiales. Elle montre aussi très bien que le recours à cet algorithme repose sur une justification éthique fondée sur la promotion du libre choix scolaire, et considère la justice comme le respect de l’ordre des priorités exprimés, présupposant l’existence de candidats « individuels, rationnels, stratèges » qui ont un projet scolaire clairement élaboré et qui sont capables de produire une liste de choix hiérarchisés tenant compte de leur projet comme de leurs chances de succès.

Leila Frouillou tackles, through the analysis of the Admission Post-Bac (APB) program, the use of an algorithm as a tool of government. Viewing this system of allocating school populations as a form of predictive management of student behaviour, she explores the way algorithms “contribute to performing the social world”. Analysing the real practices of secondary school pupils in the uses of APB, she shows that this program is a powerful tool for the reproduction of socio-spatial inequalities. She also shows very clearly that the use of this algorithm relies on an ethical justification based on the promotion of free school choice, and sees justice as a matter of following the order of priorities, presupposing the existence of “individual, rational, strategic” candidates who have a clearly developed educational plan and are capable of producing a list of hierarchical choices that reflects that plan and their chances of success.

On retrouve ces effets de normation chez Pierre Gautreau et Matthieu Noucher qui s’interrogent sur l’évolution des modes de production et de diffusion de l’information géographique depuis la transition numérique des années 90 en Bolivie, en Argentine, au Brésil, et en France. Ils discutent des différents objectifs associés à la constitution des ces Infrastructures de Données Géographiques (IDG) qu’ils définissent comme des institutions : la question du partage des données et des droits d’accès à celles-ci, de leur couverture spatiale, et de la polyvalence des informations. Cela leur permet de montrer qu’au-delà d’un discours qui promeut ces IDG en s’appuyant sur le droit à l’information, la transparence et la participation, on assiste surtout à une reprise en main par l’Etat - orchestrateur de l’interopérabilité - de ces systèmes d’information, avec des effets de filtrage, de normalisation et de formatage des données, à une segmentation de l’accès à l’information et à un resserrement de leur usage comme outil d’aide à la décision afin de « renforcer la légitimité de l’Etat comme acteur souverain du développement territorial ». Les collectivités locales et autres acteurs issus de la société civile ne sont pas contraints de communiquer leurs données mais le font « librement » pour répondre à l’injonction éthique du partage et du droit à l’information des citoyens, tendant à accréditer la thèse, développée en termes foucaldiens dans l’article suivant, du passage de la discipline à la sécurité, voire à une gouvernementalité algorithmique.

The same normative effects are encountered in Pierre Gautreau and Matthieu Noucher who explore the change in the methods of producing and distributing geographical information in Bolivia, Argentina, Brazil and France since the digital transition of the 1990s. They discuss the different objectives associated with the establishment of these Geographical Data Infrastructures (GDI), which they define as institutions: the question of data sharing and data access rights, spatial coverage, the versatility of the information. This enables them to show that, beyond the rhetoric that promotes these GDI in terms of the right to information, transparency and participation, what we are seeing above all is a takeover of these information systems by the state – as the orchestrator of interoperability – with data filtering, normalisation and formatting effects, as well as a segmentation of access to information and a clamping down on their use as a decision-making tool in order to “reinforce the legitimacy of the state as the sovereign agent of territorial development”. Local authorities and other civil society actors are not forced to communicate their data but do it “freely” in response to the ethical principle of sharing and the right of citizens to information, tending to confirm the thesis, developed in Foucauldian terms in the next article, of the transition from discipline to security, or even to algorithmic governmentality.

En effet, Nuno Rodrigues discute des liens entre formes de gouvernementalité et technologie, et des enjeux que cela représente pour la production de nos sociétés. En s’appuyant sur l’exemple du développement des projets de smart cities, il se demande, dans une démarche d’actualisation de l’approche foucaldienne, si les technologies numériques sont à l’origine de l’émergence d’une nouvelle gouvernementalité qui serait « algorithmique ». Il analyse les rationalités inhérentes à ces projets pour montrer les modes d’assujettissement et de « conduite des conduites » qu’ils induisent et leurs capacités à produire des injustices spatiales. Le rapport entre technologie et société est cœur de son propos, les techniques numériques ne pouvant selon lui pas être abordées exclusivement à travers une approche instrumentale ou substantive qui ne prend pas en compte le rôle actif de la technologie sur le façonnement du monde.

Indeed, Nuno Rodrigues discusses the links between forms of governmentality and technology, and the challenge this represents for the production of our societies. Drawing on the example of the development of plans for smart cities, he wonders – in an updating of the Foucauldian approach – whether digital technologies are behind the emergence of a new governmentality that is “algorithmic”. He analyses the rationalities inherent in these projects to show the methods of subjection and “behaviour management” that they bring about and their capacity to produce spatial injustices. The relation between technology and society is at the heart of his thesis, since in his view digital techniques cannot be tackled exclusively through an instrumental or substantive approach, since this fails to take account of the active role of technology in fashioning the world.

Cette question est également centrale dans la réflexion présentée par Eric Arrivé. Il analyse le protocole Bitcoin, l’une des crypto-monnaies les plus connues, dont il nous explique le fonctionnement et les principes et notamment le principe de transparence collaborative sur lequel il repose et qui, pour ses utilisateurs, définit sa valeur de justice. Il s’intéresse notamment à la notion de « preuve de travail » qui garantit l’authenticité des transactions effectuées. Ces preuves de travail sont issues d’un travail de « minage » totalement déconnecté du contenu réel des transactions. Il repose sur une mise en concurrence des « mineurs » qui cherchent à produire ces preuves, et conduit à une croissance exponentielle et indéfinie de la puissance de calcul globale requise par ce protocole, qui n’a d’autre forme de régulation que la dynamique propre au système lui-même. Malgré l’immatérialité de la crypto-monnaie, la puissance de calcul nécessaire à son existence à des effets bien concrets en terme d’impact environnemental et de localisation d’infrastructures industrielles de type data-center à proximité de sources d’énergie bon marché. La déconnexion totale entre le travail de minage et le contenu des transactions du protocole Bitcoin est pour lui emblématique de la dialectique concret-abstrait qui caractérise tant l’outil informatique que la production marchande telle que l’a critiquée Marx. Il s’interroge sur la possibilité même de la justice dans ce cadre et en appelle à une critique des ressorts profonds et des effets concrets du développement des technologies numériques, à l’image de celle qu’avait formulée Marx à l'ère industrielle.

This question is also central in the thesis developed by Eric Arrivé. He analyses the Bitcoin protocol, one of the best-known crypto-currencies, explaining its operation and principles, in particular the principle of collaborative transparency on which it relies and which, for its users, defines its justice value. He focuses in particular on the notion of “proof of work” which guarantees the authenticity of completed transactions. These proofs of work arise from a process of “mining” that is totally disconnected from the real content of the transactions. It is based on competition between the “miners” seeking to produce these proofs, and results in an exponential and indefinite growth in the total computing power required by the protocol, which has no form of regulation other than the system’s own dynamics. Despite the nonphysical nature of the crypto-currency, the computing power on which its existence depends has real-world effects in terms of environmental impact and industrial datacentre infrastructures located near cheap energy sources. For him, the total absence of connection between the mining task and the content of transactions in the Bitcoin protocol is emblematic of the dialectic between concrete and abstract that characterises both the IT tool and commodity production as critiqued by Marx. He questions the very possibility of justice within this framework and calls for a critique of the driving forces and concrete effects of the development of digital technologies, like that formulated by Marx in the industrial era.

A propos des auteurs : Jean Gardin est maître de conferences à l’Université Paris 1 – UMR LADYSS, Sophie Didier est professeure à l’UPEM – Lab’Urba, Aurélie Quentin est maitre de conférences à l’Université Paris Ouest Nanterre – UMR LAVUE.

About the authors: Jean Gardin Senior lecturer, Université Paris 1 – UMR LADYSS, Sophie Didier professor UPEM – Lab’Urba, Aurélie Quentin senior lecturer Université Paris Ouest Nanterre – UMR LAVUE.

Pour citer cet article : Jean Gardin, Sophie Didier, Aurélie Quentin “Liberté, Egalité, Computer”, justice spatiale | spatial justice, n°10, Juillet 2016, http://www.jssj.org/

To quote this article: “Liberty, Equality, IT”, justice spatiale | spatial justice, n°10, July 2016, http://www.jssj.org/

[2] Né en 1940 et mort en 2013, Alain Desrosières a été formé à l’école polytechnique et à l’Ecole nationale de la statistique et de l’administration économique où il a pu suivre tout à la fois les enseignements de Pierre Bourdieu et de Raymond Barre. Administrateur à l’Insee, il devient un praticien et un théoricien de la statistique publique comme outil de gouvernement. Avec La politique des grands nombres (1993) et L’argument statistique I et II (2008), il s’impose comme un des plus importants sociologues de la quantification. Très attaché à la dimension politique de l’argument statistique, il se donne pour but d’ouvrir les boites noires que sont les « mises en équivalences » préalables à la production des chiffres. Le texte ici cité exprime notamment son attachement – voire sa nostalgie- au caractère public de la statistique, caractère selon lui nécessaire quoiqu'insuffisant à une discussion politique de la quantification.

[2] Born in 1940 and deceased in 2013, alain desrosières was educated at the école polytechnique and the école nationale de la statistique et de l’administration économique, where he was taught by both pierre bourdieu and raymond barre. an administrator at insee, he became a practitioner and theoretician of public statistics as a tool of government. With la politique des grands nombres (the politics of large numbers : a history of statistical reasoning 1993) and L’argument statistique i et ii (2008), he became one of the major figures in the sociology of quantification. very interested in the political dimension of statistical arguments, he made it his goal to open up the black boxes of the “equivalence method” applied to the production of numbers. the text quoted here expresses in particular his attachment to – even his nostalgia for – for the public nature of statistics, something that he saw as necessary though not sufficient to a political discussion of quantification.

[3] Comme l’explique très bien IBM : « Chaque jour, nous générons 2,5 trillions d’octets de données. A tel point que 90% des données dans le monde ont été créées au cours des deux dernières années seulement. Ces données proviennent de partout : de capteurs utilisés pour collecter les informations climatiques, de messages sur les sites de médias sociaux, d'images numériques et de vidéos publiées en ligne, d'enregistrements transactionnels d'achats en ligne et de signaux GPS de téléphones mobiles, pour ne citer que quelques sources. Ces données sont appelées Big Data ou volumes massifs de données ». https://www-01.ibm.com/software/fr/data/bigdata/

[3] As the IBM website itself explains very clearly: « everyday, we generate 2.5 trillion octets of data. so much so that 90% of all data in the world were produced in the past two years only. This data comes from everywhere: from sensors used to collect climate information, from messages posted on social media sites, from digital photography and videos uploaded on the web, from transactional online purchases and from the gps signals of mobile phones, to name just a few. this data is called big data. » (https://www-01.ibm.com/software/fr/data/bigdata/ : accédé le 2 juillet 2016)

[4] L'expression de Little sisters désigne la capacité de surveillance détenue par les utilisateurs des multiples opérateurs en données que sont les réseaux sociaux de type Google ou Facebook. Le terme a été notamment popularisé par Jan Chipchase, un consultant spécialiste des comportements des consommateurs et des nouvelles technologies : « When it comes to surveillance most people think of big brother, but increasingly its your (early adopting, tech savvy, sensor loaded) little sister. Which makes the whole notion of opting out of technology adoption one of whether to opt out of society. » blog FuturePerfect, entrée du 29 février 2008 : http://janchipchase.com/2008/02/big-brother-little-sister/.

[4] The expression Little Sisters refers to the surveillance capacity held by the users of the multiple data operators that make up social networks like Google or Facebook. The term was popularised in particular by Jan Chipchase, a consultant specialising in consumer behaviour and new technologies: “When it comes to surveillance most people think of big brother, but increasingly it’s your (early adopting, tech savvy, sensor loaded) little sister.Which makes the whole notion of opting out of technology adoption one of whether to opt out of society.” FuturePerfect blog, posting of 29 February 2008: http://janchipchase.com/2008/02/big-brother-little-sister/.

[5] A l’image des études d’impact randomisées ou Randomised Control Trial (RCT) popularisées par Esther Duflo, qui se multiplient depuis une dizaine d’années pour évaluer les politiques publiques (Duflo 2005, Bernajii, Duflo 2009, et pour une critique de cette procédure RCT : Labrousse 2010).

[5] Like the Randomised Control Trials (RCT) popularised by Esther Duflo, which have proliferated in the last 10 years or so as a way of assessing public policies (Duflo 2005, Bernajii, Duflo 2009, and for a critical perspective on this RCT procedure : Labrousse 2010).